Группа исследователей предупреждает, что популярные модели изображений с искусственным интеллектом, такие как DALL-E 2, могут быть «обманутыми» для восстановления своих тренировочных изображений.

Это серьезная проблема конфиденциальности, особенно с учетом того, что ИИ применяется к все более чувствительным классам изображений, например, в медицинских приложениях.

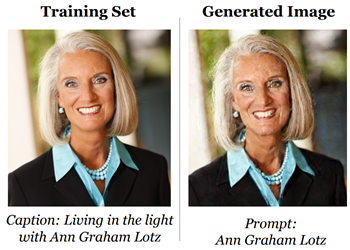

Команда, в которую входят исследователи из Google Brain, DeepMind, ETH Zurich, Принстонского университета и Калифорнийского университета в Беркли, продемонстрировала, что класс генераторов изображений, известный как модели генеративной диффузии, запоминает и регенерирует свои обучающие данные, что «нарушило бы всю конфиденциальность». гарантии», а также поднятие вопросов о создании моделей и «цифровой подделке» (модели, воспроизводящей произведения, защищенные авторским правом).

Они протестировали модели Stable Diffusion и Imagen и извлекли «более сотни почти идентичных копий обучающих изображений, которые варьируются от личных фотографий до логотипов с товарными знаками».

Бумага, опубликовано на arXiv«подчеркивает противоречие между все более мощными генеративными моделями и конфиденциальностью данных и поднимает вопросы о том, как работают модели распространения и как их следует ответственно развертывать».

Например, исследователи отметили, что такие области, как медицинские исследования, очень чувствительны к конфиденциальности: класс машинного обучения, называемый генеративно-состязательной сетью (GAN), уже применялся к медицинским изображениям, говорится в документе, что «подчеркивает важность понимания риски генеративных моделей, прежде чем мы применим их к частным доменам».

«Исследователи и практики должны с осторожностью относиться к обучению на некурируемых общедоступных данных, не предприняв предварительных шагов для понимания лежащих в их основе последствий для этики и конфиденциальности», — говорится в документе.

Читать полную новость на сайте

/cloudfront-us-east-2.images.arcpublishing.com/reuters/VHFFCQFFS5N4DMIACEENVLCRGE.jpg)